Qué es el Robots.txt: Guía Completa para Configurarlo

Actualizado: diciembre 2025

¿Quieres controlar qué páginas de tu web rastrea Google? El archivo robots.txt es la herramienta que te permite dar instrucciones a los buscadores sobre qué partes de tu sitio deben visitar y cuáles deben ignorar.

En esta guía te explicamos qué es el robots.txt, cómo funciona, cómo crearlo correctamente y los errores más comunes que debes evitar. Un archivo mal configurado puede bloquear el acceso a contenido importante y arruinar tu posicionamiento.

Lo que aprenderás en esta guía

- Qué es robots.txt: Definición y función principal

- Sintaxis y directivas: User-agent, Disallow, Allow, Sitemap

- Cómo crearlo: Paso a paso con ejemplos

- Errores comunes: Lo que NO debes hacer

- Verificación: Cómo comprobar que funciona correctamente

¿Qué es el archivo robots.txt?

El robots.txt es un archivo de texto plano ubicado en la raíz de un sitio web que proporciona instrucciones a los rastreadores de los buscadores (como Googlebot) sobre qué páginas o secciones pueden o no pueden rastrear.

Forma parte del Protocolo de Exclusión de Robots, un estándar que los buscadores respetan voluntariamente. Es importante entender que es una recomendación, no una orden obligatoria ni un método de seguridad.

¿Dónde se encuentra?

Siempre en la raíz del dominio: https://tudominio.com/robots.txt

Puedes ver el robots.txt de cualquier web añadiendo /robots.txt a su dominio. Pruébalo con webs conocidas para ver ejemplos reales.

¿Para qué sirve?

- Gestionar el rastreo: Evitar que los bots pierdan tiempo en páginas irrelevantes

- Proteger recursos: Impedir el rastreo de áreas administrativas o en desarrollo

- Optimizar crawl budget: Priorizar el rastreo de contenido importante

- Indicar el sitemap: Señalar dónde está tu sitemap

Sintaxis y directivas del robots.txt

El robots.txt tiene una sintaxis sencilla basada en directivas. Cada directiva ocupa una línea:

User-agent

Indica a qué rastreador van dirigidas las instrucciones:

User-agent: *→ Todos los rastreadoresUser-agent: Googlebot→ Solo el bot de GoogleUser-agent: Bingbot→ Solo el bot de Bing

Disallow

Indica qué rutas NO deben rastrearse:

Disallow: /admin/→ Bloquea la carpeta adminDisallow: /privado.html→ Bloquea una página específicaDisallow: /→ Bloquea TODO el sitioDisallow:(vacío) → No bloquea nada

Allow

Permite rastrear una ruta dentro de una bloqueada:

Disallow: /carpeta/Allow: /carpeta/publico.html→ Permite solo esa página

Sitemap

Indica la ubicación del sitemap XML:

Sitemap: https://tudominio.com/sitemap.xml

Ejemplos de configuración robots.txt

Veamos ejemplos prácticos de configuraciones de robots.txt según diferentes necesidades:

Permitir todo (configuración mínima)

User-agent: *

Allow: /

Sitemap: https://tudominio.com/sitemap.xml

Bloquear una carpeta

User-agent: *

Disallow: /admin/

Disallow: /wp-admin/

Sitemap: https://tudominio.com/sitemap.xml

Bloquear páginas con parámetros

User-agent: *

Disallow: /*?*

Disallow: /search/

Sitemap: https://tudominio.com/sitemap.xml

Configuración típica para WordPress

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Disallow: /wp-includes/

Disallow: /trackback/

Disallow: /feed/

Disallow: /*?s=

Disallow: /*?p=

Sitemap: https://tudominio.com/sitemap_index.xml

Bloquear todo el sitio (mantenimiento)

User-agent: *

Disallow: /

¡Cuidado! Esto impide que Google rastree cualquier página. Solo usar temporalmente.

Cómo crear un robots.txt paso a paso

Crear un robots.txt es sencillo. Solo necesitas un editor de texto:

Paso 1: Crea el archivo

Abre el Bloc de notas, TextEdit o cualquier editor de texto plano. No uses Word ni editores de texto enriquecido.

Paso 2: Escribe las directivas

Empieza con la configuración básica:

User-agent: *

Allow: /

Sitemap: https://tudominio.com/sitemap.xml

Añade las directivas Disallow que necesites según tu caso.

Paso 3: Guarda el archivo

Guárdalo exactamente como robots.txt (todo en minúsculas, sin extensión adicional).

Paso 4: Súbelo a la raíz

Sube el archivo a la raíz de tu dominio mediante FTP o el gestor de archivos de tu hosting. Debe ser accesible en: tudominio.com/robots.txt

Paso 5: Verifica

Abre tudominio.com/robots.txt en el navegador para confirmar que funciona correctamente.

Robots.txt en WordPress

Si usas WordPress, tienes varias opciones para gestionar el robots.txt:

Con Yoast SEO

- Ve a Yoast SEO → Herramientas → Editor de archivos

- Verás el contenido actual del robots.txt

- Edita las directivas según tus necesidades

- Guarda los cambios

Con Rank Math

- Ve a Rank Math → Ajustes Generales → Editar robots.txt

- Modifica el contenido

- Guarda los cambios

Robots.txt virtual vs físico

WordPress genera un robots.txt virtual por defecto. Los plugins SEO suelen crear uno físico que tiene prioridad. Si tienes problemas, comprueba que no haya conflictos entre ambos.

Cuidado con la opción de visibilidad

En Ajustes → Lectura, si marcas «Disuadir a los motores de búsqueda», WordPress añade automáticamente un Disallow que bloquea todo el sitio. Asegúrate de que esta opción esté desmarcada en producción.

Rastreo vs indexación: diferencia clave

Es crucial entender que el robots.txt controla el rastreo, no la indexación:

Rastreo vs Indexación

- Rastreo: El bot visita y lee la página

- Indexación: Google añade la página a su índice de resultados

Si bloqueas una URL en robots.txt, Google no la rastreará. Pero si hay enlaces externos apuntando a ella, Google puede indexarla sin contenido, mostrando en los resultados algo como «No hay información disponible para esta página».

¿Cómo evitar la indexación correctamente?

Si quieres que una página NO aparezca en Google, usa la etiqueta meta noindex:

<meta name="robots" content="noindex">

Y no la bloquees en robots.txt, porque entonces Google no podrá leer la etiqueta noindex.

Resumen

- No quiero que Google rastree: Usa robots.txt

- No quiero que Google indexe: Usa meta noindex

- No quiero ninguna de las dos: Usa noindex (sin bloquear en robots.txt)

Cómo verificar tu robots.txt

El robots.txt es una herramienta básica pero fundamental del SEO técnico. Una configuración incorrecta puede bloquear contenido importante y afectar seriamente a tu posicionamiento, mientras que una configuración óptima ayuda a Google a rastrear tu sitio de forma eficiente.

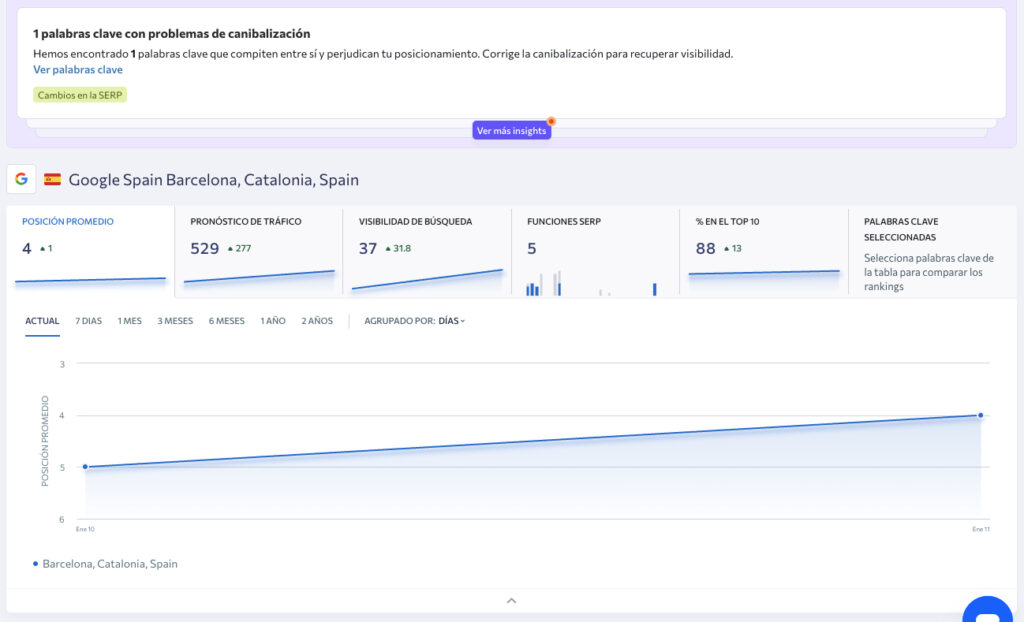

En JRC Web revisamos y optimizamos todos los aspectos técnicos de tu web, incluyendo robots.txt, sitemaps, canonicals y estructura de URLs. Como agencia SEO en Barcelona, nos aseguramos de que tu web esté correctamente configurada para los buscadores.

Una auditoría SEO completa incluye la revisión de todos estos elementos técnicos para detectar y corregir problemas que podrían estar frenando tu posicionamiento.

¿Tienes dudas sobre la configuración técnica de tu web? Contacta con nosotros y analizamos tu caso sin compromiso.

Errores comunes en robots.txt

Google ofrece herramientas para verificar que tu robots.txt funciona correctamente:

Probador de robots.txt en Search Console

- Accede a Google Search Console

- Ve a Ajustes → Abrir robots.txt

- O usa la herramienta antigua: search.google.com/test/robots-testing-tool

- Introduce una URL de tu sitio para probar si está bloqueada o permitida

Qué verificar

- Sintaxis correcta: La herramienta señala errores de formato

- URLs importantes permitidas: Prueba tus páginas principales

- URLs privadas bloqueadas: Comprueba que /admin/ y similares están bloqueadas

- Sitemap accesible: La URL del sitemap debe funcionar

Informe de cobertura

En Search Console, el informe de Páginas te muestra si hay URLs bloqueadas por robots.txt. Si ves páginas importantes en esta categoría, revisa tu configuración.

Robots.txt y crawl budget

Estos errores pueden afectar seriamente a tu SEO:

1. Bloquear todo el sitio accidentalmente

Disallow: / bloquea absolutamente todo. A veces se deja esta línea de un entorno de desarrollo y se sube a producción por error. Verifica siempre antes de subir.

2. Bloquear recursos CSS y JavaScript

Google necesita acceder a CSS y JS para renderizar las páginas correctamente. Bloquearlos afecta cómo Google interpreta tu contenido y puede perjudicar el posicionamiento.

3. Bloquear páginas y esperar que no se indexen

Como vimos, bloquear en robots.txt no impide la indexación. Si hay enlaces externos, Google puede indexar la URL mostrando un resultado vacío.

4. Usar robots.txt para ocultar contenido sensible

El archivo es público. Cualquiera puede leerlo y ver qué estás «ocultando». No es un método de seguridad.

5. No incluir el sitemap

Añadir la referencia al sitemap en robots.txt ayuda a los buscadores a encontrarlo. Es una buena práctica que no tiene coste.

Principales user-agents de buscadores

El concepto de crawl budget (presupuesto de rastreo) es especialmente relevante para sitios grandes:

¿Qué es el crawl budget?

Es el número de páginas que Google está dispuesto a rastrear en tu sitio en un período determinado. Depende de la importancia de tu sitio y de la capacidad de tu servidor.

¿Cuándo importa?

- Sitios con más de 10.000 páginas

- Sitios con muchas URLs generadas dinámicamente

- Sitios con contenido que cambia frecuentemente

Cómo optimizarlo con robots.txt

- Bloquea páginas de bajo valor: Búsquedas internas, filtros, ordenaciones

- Bloquea parámetros de tracking: UTMs, IDs de sesión

- Bloquea paginación profunda: /page/50/, /page/100/

- Permite lo importante: Asegura que el contenido clave no esté bloqueado

Para sitios pequeños (menos de 1.000 páginas), el crawl budget rara vez es un problema.

Robots.txt y otras herramientas SEO

Cada bot de buscador tiene su propio nombre (user-agent). Los más importantes:

Bots de Google

- Googlebot: Rastreador principal de Google Search

- Googlebot-Image: Rastreador de imágenes

- Googlebot-Video: Rastreador de vídeos

- Googlebot-News: Rastreador de Google News

- AdsBot-Google: Rastreador de calidad de anuncios

Bots de otros buscadores

- Bingbot: Microsoft Bing

- Slurp: Yahoo

- DuckDuckBot: DuckDuckGo

- Baiduspider: Baidu (China)

- Yandex: Yandex (Rusia)

Configuración diferenciada

Puedes dar instrucciones diferentes a cada bot:

User-agent: Googlebot

Disallow: /privado/

User-agent: Bingbot

Disallow: /privado/

Disallow: /otro/

Preguntas frecuentes sobre robots.txt

¡Haz clic para puntuar esta entrada!

¿De cuánta utilidad te ha parecido este contenido?

¡Haz clic en una estrella para puntuarlo!

¡Valoración media! 5 / 5. Recuento de votos 1

¡Aún no hay votos! Sé el primero en calificar esta publicación.